原标题:Google释出高效能切割模型ShapeMask

Google开发了一种称为ShapeMask的实例切割演算法,能辨识图像中的物体实例,并且产生高精确度的遮罩,现在Google开源ShapeMask模型,让社群有办法以兼具速度和精确度的方法产生图像物件遮罩。

要以程式辨识各种形状、颜色和大小并非简单的工作,但这些工作对于医学图像分析,和照片编辑等应用来说十分重要,因此Google开发出了新图像分割模型ShapeMask。ShapeMask可辨识并追蹤特定物件实例的边界,像是城市街道上有多辆汽车的图像,ShapeMask可以突出显示图像中每辆不同颜色大小的汽车,而突出显示的区域就称为遮罩。

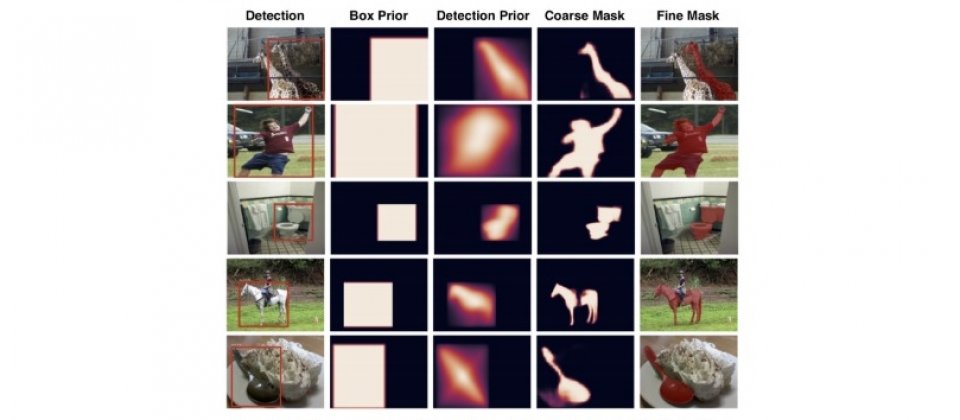

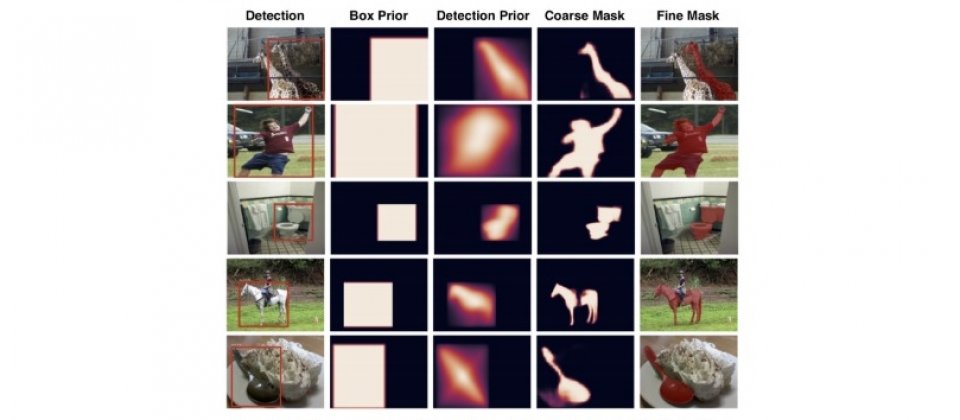

ShapeMask是利用着名的物件侦测模型RetinaNet,来侦测图像中各种物件的位置和大小,但是RetinaNet模型并无法产生物件的遮罩,因此Google在以RetinaNet定位物件之后,会将相似外观的画素进行分组,逐步完善侦测到的物件形状,最终产生精确的遮罩。

Google提到,对于依赖自动化图像分割的应用程式,开发者通常需要使用大型资料集,且又需要频繁的变更资料集,为了快速迭代大型逼真的资料集,企业需要扩展图像分割模型训练的规模。

而ShapeMask在大批次的训练,比其他图像分割模型还要有效率得多,因为ShapeMask可以在大数量的机器学习加速器上,进行分散式的ShapeMask训练。Google以256核心的Cloud TPU v3分片,在40分钟内就可以完成以COCO图像分割资料集训练ShapeMask模型,这比起8核心的单一Cloud TPU装置所花费的数小时,还要快上许多,而且无论以哪一种规模的Cloud TPU Pod来运算ShapeMask模型,都不需要修改任何程式码。

相关阅读

猜您喜欢

- 科技快讯:越南最大通信运营商采用诺基亚和爱立信5G设备 于2020年启动商用

- 老婆天天查手机装定位(免费查手机定位)

- 苹果手机怎样查几天前的定位(怎样查苹果手机位置信息)

- 魅族手机丢失怎么查定位系统(电话丢了怎么定位找到)

- 国外住酒店记录网上查的到吗(宾馆能查到以前的信息吗)

- 三星Galaxy Note 7印度8月11日发布: 这是你需要知道的一切

- 松江南站动迁房怎么样(松江动迁房有哪几个地方啊)

- 手机关机前的最后定位如何查(怎么能找到关机的手机位置)

- COAI批评TRAI的call connect评论; 称其为不公平

- 手机APP教程篇:微信转账怎么转到零钱通

- 御多少钱一瓶(同仁堂御酒多少钱一瓶)

- Reliance LYF Wind 3与Jio 4g预览优惠从8月10日开始销售

- 科技快讯:金山股份发布2020年财报营收72.87亿元同比减少1.55%

- oppo怎么查手机定位(oppo手机怎么找定位)

- 为什么Instagram Stories可能会赢得老年观众和发展中市场

- 怎么查男朋友微信朋友圈评论别人能看到吗(查男友手机微信聊天记录)

图文推荐

热门文章

-

1

1Google释出高效能切割模型ShapeMask

通信 2022-04-10 15:04:56 -

2

2电脑如何设置壁纸(电脑如何设置壁纸和锁屏)

数码 2022-04-10 15:04:43 -

3

3甘肃的大学有哪些(甘肃一本大学有几个)

评论 2022-04-10 15:04:27 -

4

电信手机怎么查定位(怎么查手机位置)

手机 2022-04-10 15:04:24 -

5

怎样查老婆的位置(手机位置怎么查踪迹)

原创 2022-04-10 15:04:21 -

6

科技快讯:越南最大通信运营商采用诺基亚和爱立信5G设备 于2020年启动商用

通信 2022-04-10 15:04:19